Lucro do BB tomba 60% no 2º tri; banco reduz payout para 30%

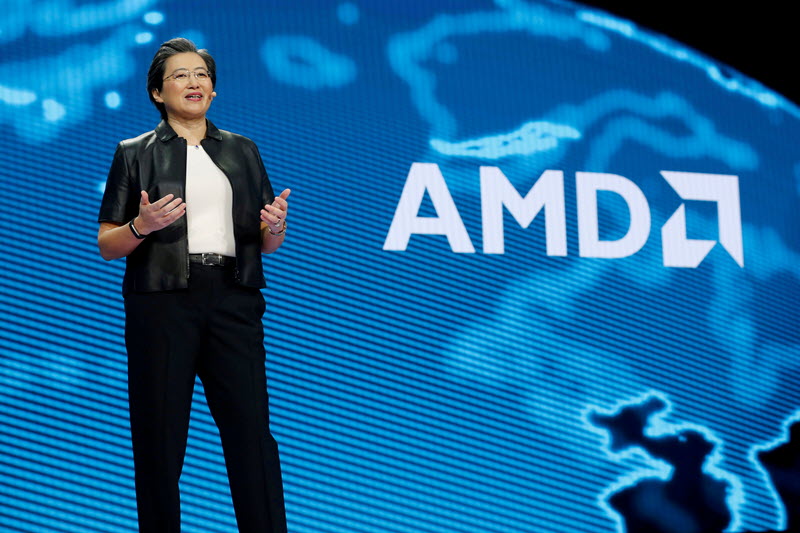

SÃO FRANCISCO - A Advanced Micro Devices, Inc. (NASDAQ: AMD (NASDAQ:AMD)) revelou na quinta-feira uma série de novos produtos destinados a melhorar o desempenho da infraestrutura de IA, incluindo os aceleradores AMD Instinct MI325X e componentes de rede como o AMD Pensando Salina DPU e o Pollara 400 NIC. Essas ofertas são projetadas para atender às crescentes demandas de aplicações de IA e data centers.

Os aceleradores AMD Instinct MI325X, construídos com base na arquitetura AMD CDNA 3, prometem oferecer melhorias significativas no desempenho de IA, apresentando 256GB de memória HBM3E e 6,0TB/s de largura de banda. Isso representa um aumento na capacidade de memória e largura de banda em comparação com modelos anteriores, com o MI325X oferecendo 1,3 vezes o desempenho teórico máximo de computação FP16 e FP8.

A AMD anunciou que as remessas de produção dos aceleradores MI325X devem começar no quarto trimestre de 2024, com ampla disponibilidade de sistemas de parceiros como Dell Technologies, HPE, Lenovo e Supermicro a partir do primeiro trimestre de 2025.

Olhando para o futuro, a AMD apresentou uma prévia de seus aceleradores da próxima geração da série Instinct MI350, baseados na futura arquitetura AMD CDNA 4. Espera-se que esses aceleradores proporcionem uma melhoria de 35 vezes no desempenho de inferência em comparação com os aceleradores atuais baseados em CDNA 3 e estão programados para lançamento no segundo semestre de 2025.

No campo de redes de IA, a AMD introduziu o AMD Pensando Salina DPU e o AMD Pensando Pollara 400 NIC. O Salina DPU foi projetado para otimizar clusters de rede front-end, oferecendo até 2 vezes o desempenho e a largura de banda de seu antecessor. O Pollara 400 NIC, o primeiro NIC de IA pronto para o Ultra Ethernet Consortium (UEC) da indústria, está configurado para melhorar o desempenho da rede back-end. Ambos os componentes estão atualmente em fase de amostragem com clientes e devem estar disponíveis no primeiro semestre de 2025.

Além disso, a AMD continua investindo em capacidades de software, avançando sua pilha de software aberto ROCm para suportar cargas de trabalho de IA generativa. A mais recente atualização ROCm 6.2 inclui novos recursos destinados a melhorar o desempenho de inferência e treinamento de IA.

Este anúncio é baseado em um comunicado à imprensa da AMD e reflete o compromisso contínuo da empresa com a inovação em computação de alto desempenho e tecnologia de IA.

Em outras notícias recentes, a Advanced Micro Devices (AMD) está avançando no mercado de chips de IA com o lançamento de novos processadores, incluindo os aguardados chips MI325X e MI350. A empresa também anunciou planos para lançar novas CPUs de servidor e chips para PC com capacidades avançadas de IA. A previsão de receita de chips de IA da AMD foi ajustada para 4,5 bilhões de dólares para o ano devido à alta demanda, particularmente do setor de produtos de IA generativa.

Analistas da Cantor Fitzgerald e Goldman Sachs mantiveram avaliações positivas para a AMD, destacando anúncios significativos no evento Advancing AI da AMD e as iniciativas estratégicas da empresa. As receitas do segundo trimestre da AMD superaram o consenso da Street, atingindo 5,835 bilhões de dólares, com seu segmento de data center mostrando um crescimento recorde de receita de 115% para 2,8 bilhões de dólares.

A crescente presença da AMD no setor de computação em nuvem é ainda mais enfatizada por sua recente colaboração com a Oracle Cloud Infrastructure (OCI). Os aceleradores AMD Instinct MI300X alimentarão o novo supercluster de IA da OCI, projetado para lidar com cargas de trabalho complexas de IA. Os primeiros adotantes dessa oferta incluem a Fireworks AI, que escalou efetivamente seus serviços usando a capacidade de memória aprimorada do AMD Instinct MI300X.

Esses desenvolvimentos recentes refletem o compromisso da AMD em fornecer soluções de computação de alto desempenho para aplicações de IA e seu ecossistema de soluções de IA em expansão. No entanto, apesar desses esforços, não se espera que afete significativamente a receita de data center da Nvidia, já que a demanda por chips de IA atualmente supera a oferta.

Insights do InvestingPro

Os recentes anúncios de produtos da AMD estão alinhados com sua forte posição de mercado e desempenho financeiro. De acordo com os dados do InvestingPro, a AMD possui uma capitalização de mercado substancial de 266,13 bilhões de dólares, refletindo a confiança dos investidores em seu potencial de crescimento. A receita da empresa de 23,28 bilhões de dólares nos últimos doze meses até o segundo trimestre de 2024 demonstra sua significativa presença no mercado na indústria de semicondutores.

As dicas do InvestingPro destacam a AMD como uma "proeminente player na indústria de Semicondutores e Equipamentos de Semicondutores", o que é evidente em sua inovadora linha de produtos focados em IA. O foco da empresa em computação de alto desempenho e tecnologia de IA provavelmente contribuirá para o crescimento esperado do lucro líquido este ano, outro insight fornecido pelo InvestingPro.

A saúde financeira da AMD parece robusta, com dados do InvestingPro mostrando que "ativos líquidos excedem obrigações de curto prazo", sugerindo que a empresa está bem posicionada para investir em P&D e trazer novos produtos ao mercado. Essa estabilidade financeira suporta o ambicioso roteiro de produtos da AMD, incluindo o lançamento de aceleradores e componentes de rede de próxima geração.

Os investidores devem notar que a AMD está "negociando a um múltiplo de lucros elevado", o que pode refletir as expectativas do mercado para o crescimento futuro impulsionado pela demanda de IA e data center. O forte retorno da empresa no último ano (56,88% de retorno total do preço) e na década indica um interesse sustentado dos investidores nas perspectivas de longo prazo da AMD.

Para aqueles interessados em uma análise mais profunda, o InvestingPro oferece 16 dicas adicionais para a AMD, fornecendo uma visão abrangente da saúde financeira e posição de mercado da empresa.

Essa notícia foi traduzida com a ajuda de inteligência artificial. Para mais informação, veja nossos Termos de Uso.